25/03/2025 22:43

25/03/2025 22:43

25/03/2025 22:41

25/03/2025 22:40

25/03/2025 22:40

25/03/2025 22:39

25/03/2025 22:38

25/03/2025 22:37

25/03/2025 22:36

25/03/2025 22:35

» El Ciudadano

Fecha: 24/03/2025 03:33

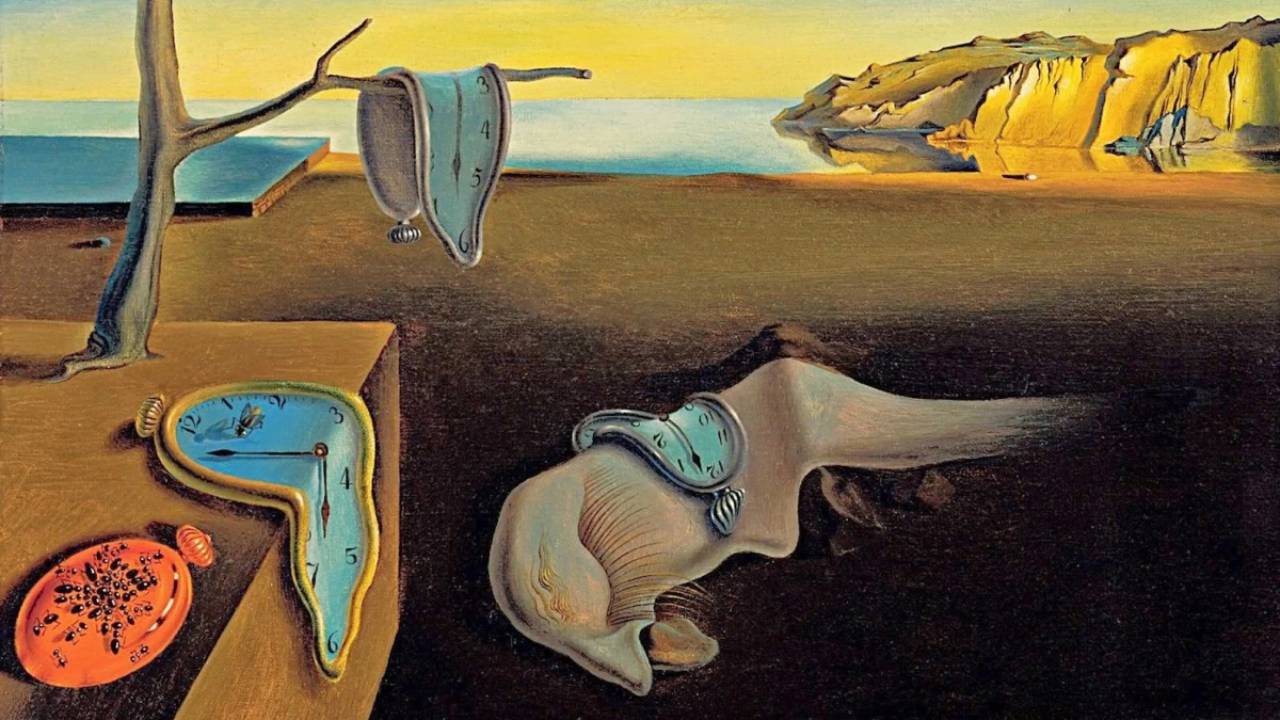

Desde hace años, la inteligencia artificial (IA) ha logrado hazañas que parecían inalcanzables como escribir poesía, diagnosticar enfermedades, crear imágenes hiperrealistas, traducir lenguas con fluidez o resolver ecuaciones complejas; pero una nueva investigación reveló un límite inesperado en su capacidad: no sabe leer la hora en un reloj analógico. Sí, justo ese gesto simple que millones de personas aprenden en la infancia, a menudo antes de saber multiplicar, resulta ser una de las tareas más difíciles para los sistemas de IA multimodales. Así lo confirmó un estudio de la Universidad de Edimburgo, liderado por Rohit Saxena, que puso a prueba modelos avanzados como GPT-4 de OpenAI y Gemini 2.0 de Google. Qué reveló sobre los errores de la IA el estudio Investigadores descubrieron que modelos multimodales como GPT-4 interpretan mal la posición de las agujas, mostrando dificultades para comprender relaciones espaciales simples. La investigación se centró en una habilidad tan básica como interpretar la posición de las agujas en distintos tipos de relojes analógicos. Los resultados evidenciaron la falencia de la IA. Los modelos acertaron en menos del 25% de los casos. En otras palabras, tres de cada cuatro veces interpretaron mal la hora. La tasa de error se mantuvo alta incluso cuando se simplificaban las condiciones del experimento, como eliminar el segundero. Además, los errores aumentaron cuando los relojes mostraban números romanos o agujas estilizadas, lo que indica que no se trata solo de un fallo técnico puntual, sino más bien de una incapacidad más profunda para reconocer patrones visuales e interpretar relaciones angulares. Esto representa una paradoja. Mientras que la IA puede detectar tumores en imágenes médicas con una precisión asombrosa o analizar millones de datos en segundos, no logra identificar correctamente dónde apunta una aguja corta o larga, ni relacionar su posición con un número. Lo que para un niño de 7 años es intuitivo, para un modelo de última generación representa una barrera. La inteligencia artificial y su problema con los calendarios Pero el problema no termina ahí. Los investigadores también probaron cómo los modelos de IA manejaban tareas relacionadas con calendarios, como calcular fechas futuras, identificar feriados o interpretar referencias temporales. En este campo, los errores rondaron el 20%, incluso en los sistemas más avanzados. Aunque en apariencia se trata de errores menores, su impacto es considerable. La falta de precisión en operaciones basadas en tiempo limita seriamente el uso de IA en aplicaciones críticas como planificación automática, asistencia en programación, coordinación de tareas o navegación en entornos dinámicos, como el de los robots autónomos. Cuál sería la razón de los errores de la IA Una de las claves está en la naturaleza de los modelos actuales. Las herramientas multimodales están diseñadas para procesar texto e imágenes, pero no siempre tienen una comprensión real del contenido visual que analizan. Aunque pueden describir una imagen con gran detalle, carecen de un modelo interno que relacione esos datos con conceptos espaciales concretos, como ángulos o proporciones. Leer un reloj analógico no se trata solo de reconocer formas, es de interpretar la posición relativa de dos agujas en función de una escala circular. Esa relación, que para los humanos se traduce casi automáticamente en una lectura de la hora, exige una comprensión geométrica que los modelos aún no han dominado. En el caso del calendario, el desafío se vuelve aún más abstracto. Involucra reglas no explícitas, excepciones culturales, referencias contextuales y variaciones temporales. Todo eso complica aún más la capacidad de la IA para procesar el tiempo como una dimensión funcional en sus operaciones. La lectura de un reloj analógico puede parecer una prueba menor. Pero como quedó demostrado, puede exponer fisuras profundas en el diseño de herramientas de IA que, a pesar de su sofisticación, todavía no dominan el tiempo que prometen optimizar.

Ver noticia original